Um post especial sobre os novos lançamentos. Está organizado por Sistema Operativo e tem a parte do AI no final. Se quiserem mais notícias e updates, não se esqueçam de subscrever

Este post vai cobrir os principais lançamentos da Apple, pela ordem em que eles foram aparecendo no Keynote do WWDC. O AI está no final.

Episódio aqui

VisionOS 2: Mais Computação Espacial

O VisionOS 2 da Apple introduz algumas atualizações ao último grande lançamento da Apple - apenas 4 meses depois do lançamento já temos uma segunda versão do Sistema operativo. Estes updates vão no sentido de melhorar a qualidade e aumentar as funcionalidades de entretenimento, produtividade e colaboração. Aqui estão os principais destaques:

Spatial Photos e photos App: O VisionOS 2 utiliza machine learning para converter imagens 2D neste novo formato 3D das spatial photos - ou seja fotografias antigas vão poder ser vistas em 3D mesmo não tendo sido capturadas assim - cria um efeito paralax em que os sujeitos da foto são separados do background e dá algum movimento holográfico. O SharePlay agora permite ser usado na app da galeria para uma visualização conjunta das fotografias.

Navegação: Novos gestos para a navegação no Vision Pro - novos gestos para abrir o Home View, verificar o tempo e o nível da bateria e abrir a Central de Controlo.

Display Virtual do Mac: O Vision Pro agora suporta uma resolução e tamanho mais altos, expandindo-se para um display ultrawide equivalente a dois monitores 4K.

APIs para Developers: Novos frameworks e APIs para facilitar o desenvolvimento de apps para o Vision Pro - uma das críticas que se fez a este produto foi exatamente a falta de apps para além das nativas. Construir uma aplicação para uma plataforma nova, com funcionalidades novas e um modo de interação totalmente novo é um grande custo para as empresas, que certamente avançaram cautelosamente nisto.

iOS 18: Personalização e Conectividade

O iOS 18 vem trazer novas maneiras de personalizar o iPhone, e muitas features ligadas a mensagens e fotografia. Algumas das features de AI funcionam em todas as plataformas e por isso estão no final do artigo. Aqui só as do iOS:

Personalização da Home Screen: *Finalmente* é possível mover os ícones e widgets para qualquer posição no ecrã (só demoraram 18 sistemas operativos a permitir :shrug:). Mas não ficaram por aqui. Mostraram também uma funcionalidade que permite mudar o estilo dos ícones para terem um tom escuro com o modo escuro do telemóvel ou até mudar a cor dos ícones e ter um estilo mais monocromático. A este ponto não se podiam ficar só por incluir a feature que o Android tem desde o início. Houve risos e palmas no evento ao vivo

Central de Controlo: Redesenhado para maior extensibilidade, agora com novos controlos disponíveis para reprodução de mídia e controlos domésticos, e uma API de Controlos para 3rd party apps.

Melhorias de Privacidade: Recursos como bloqueio de apps com Face ID, ocultação de apps sensíveis e controlos de privacidade mais detalhados para contactos e acesso a dispositivos em rede (wi-fi ou bluetooth).

Mensagens: Mais opções de reações a mensagens e novas animações para realçar texto nas mensagens. Possibilidade de agendar mensagens e de enviar mensagens via satélite para conectividade fora da rede móvel. Mencionaram rápido e sem grande detalhe a compatibilidade com RCS - um sistema de mensagens mais rico que o SMS que vai permitir ter muitas mais features em conversas com pessoas que não tenham um dispositivo Apple (imagens e vídeos com maior qualidade, encriptação end-to-end, recibos de leitura, indicador de typing, etc)

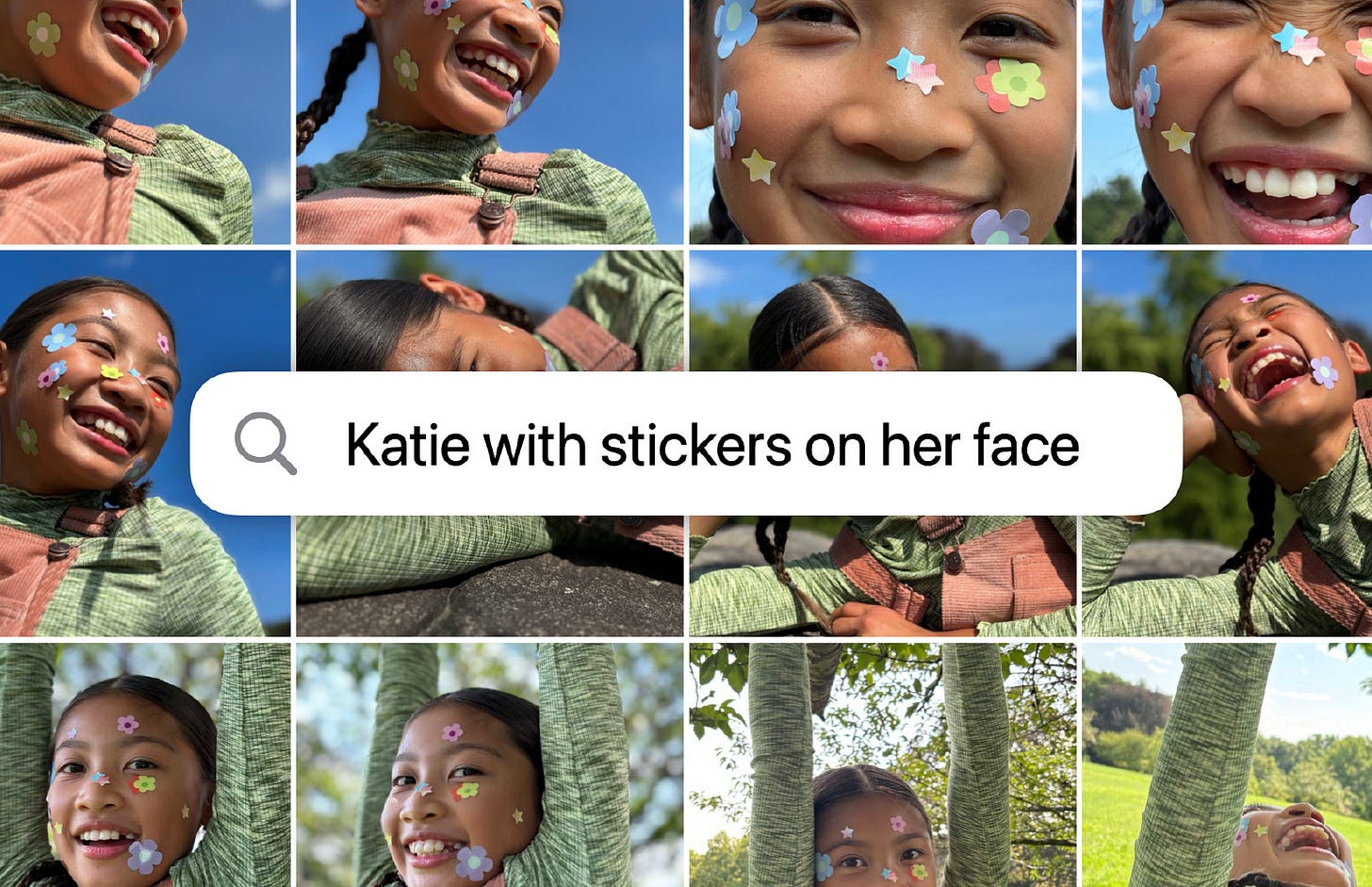

App da Galeria: Grande redesign com coleções para organizar fotos por temas como viagens e memórias favoritas ou ainda grupos de pessoas que costumam aparecer juntas muitas vezes. Adicionaram mais filtros (como remover screenshots) e mais inteligência na pesquisa por fotos e vídeos. É possível sermos altamente específicos a descrever uma fotografia. Mais inteligência na criação dos highlights - tema, música adequada, pessoas, etc

iPadOS 18: Finalmente uma calculadora

O iPadOS 18 traz poucas mudanças - ainda não foi desta que o aproximaram de um computador

Barra de Abas Flutuante: Um pequeno design tweak que parece ser geral a todas as aplicações e que aproxima a linguagem de design do VisionOS com mais transparências.

Atualizações do SharePlay e Freeform: Partilhar o ecrã agora permite controlo remoto e desenhar com o Apple Pencil. Ótimo para todos os filhos que são técnicos de IT resolverem os problemas dos pais.

Calculadora e Math Notes: Isto sim, a novidade mais aguardada a par das funcionalidade de AI. Para além das funcionalidades normais de uma calculadora, a Apple mostrou uma nova secção que funciona como quadro onde se pode desenhar e escrever problemas matemáticos. Desde equações a problemas de física, o iPad passa a ser capaz de perceber que o que foi escrito é uma equação e resolve automaticamente quando vê o sinal de ‘=’. Também reconhece variáveis e adapta o resultado à variação destas variáveis (é possível escrever x = 30 no topo da página e depois usar x nas equações). Como se não chegasse, é capaz de inserir gráficos, também ele dinâmicos à mudança dos valores das variáveis. Isto permite construir e resolver problemas diretamente no iPad e numa só aplicação porque o AI que está por trás é capaz de perceber o contexto dos dados do problema e ignorar desenhos ou texto que não é relevante para a matemática da coisa. O detalhe Apple aqui é que os resultados das equações são escritos num tipo de letra desenhado semelhante ao nosso.

Notas: Melhorias no reconhecimento de texto escrito na app das Notas. O sistema operativo agora é capaz de perceber a palavra que foi escrita e corrigir ligeiramente o desenho para o tornar mais legível. E isto significa que todas as funcionalidades que estariam disponíveis em texto máquina passam a estar disponíveis em texto escrito (alterar a posição do texto empurrando as palavras para a frente, correção ortográfica, copy e paste com o mesmo formato de letra). Mais AI subtil (a este ponto ainda não tinham mencionado nada sobre isto.

macOS Sequoia: Pouco mas um bom perk de ecossistema

O macOS Sequoia também teve poucas mudanças, no entanto teve uma que vai mudar por completo a minha maneira de trabalhar:

iPhone Mirroring: Quem nunca precisou de consultar alguma coisa no telemóvel quando ele estava noutra divisão da casa? Agora isso deixa de ser um problema. Vai ser possível abrir uma app que espelha o iPhone com todas as suas funcionalidades, a partir do Mac. Isto significa também que vai ser possível transferir ficheiros e informação entre os dois dispositivos diretamente, ao arrastar coisas de um para o outro. As notificações passam a aparecer no computador também e ao serem abertas, a app do iPhone abre automaticamente e permite responder ou agir diretamente no computador. Um bom perk para quem tem os vários dipositivos e mais um ganchinho a prender-nos ao ecossistema. Tudo o que me faça ir menos ao telemóvel é uma boa feature.

Passwords: A Apple percebeu que podia facilmente matar todo o negócio de password managers apenas ao retirar as passwords de dentro dos Definições para uma aplicação. E foi isso que fez. Muita gente usa o iCloud Keychain como password manager e eles fizeram double down nesse use case. Agora podemos ter isto sincronizado em todos os dispositivos, até em Windows. Inclui funcionalidades como gerar passwords, códigos de acesso e outras coisas do género. Pode ser isto mais um passo da Apple em direção ao mercado de Workplace? Os dispositivos em que as pessoas trabalham muitas vezes já são Apple e ficaria tudo integrado sem necessidade de aplicações externas.

Atualizações no Safari: Novos recursos como Destaques para informações relevantes e um modo Leitor sem distrações. AI subtil a reconhecer as entidades importantes em cada site e a evidenciá-las quando for necessário. Também incluiram um modo Viewer em que qualquer vídeo (independentemente do player em que está a dar) pode ser expandido e ficar em modo picture-in-picture. Todas estas features já existiam no Arc Browser.

Melhorias em Jogos: Compatibilidade aumentada para jogos e novos títulos como Assassin’s Creed Shadows otimizados para o Apple Silicon.

WatchOS 11: Saúde e atividade mais inteligentes

O WatchOS 11 traz novas maneiras de se manter ativo, saudável e conectado:

Training Load: Uma nova métrica para medir a intensidade e duração dos treinos. O objetivo é ajudar os users a adaptar os seus treinos de acordo com os esforço. Usa métricas do próprio workout, tal como métricas de sinais vitais (ritmo cradíaco, ritmo respiratório, etc)

App de Vitals: Fornece insights sobre métricas de saúde diárias, com alertas para mudanças incomuns. Depois de vários anos a medir uma série de sinais vitais parece que vamos ter a Apple a dar mais inteligência sobre o que fazer com eles ou o seu significado. Talvez tivesse demorado por alguma autorização (FDA ou EMA por ex.) ou porque passa a ser um comprimisso e reponsabilidade maior dar conselhos e mais informação sobre o estado de saúde de cada pessoa. De qualquer forma, é positivo ter mais informação que apenas as medições.

Smart Stack: Aprimorado com live activities (uber eats, jogos de futebol, etc) e sugestões de widgets mais inteligentes (ex. meteorologia se se a previsão mudar para chuva, translate se a pessoa estiver noutro país com língua diferente).

Fitness app: Mais personalização na aplicação de fitness com mais métricas dos workouts e saúde e possibilidade de ajustar os anéis dia-a-dia ou até desativá-los.

Apple Intelligence: A promessa de um AI mais Pessoal e Privado

A Apple Intelligence marca um salto significativo em AI para este colosso tecnológico, integrando modelos generativos nos dispositivos Apple para fornecer assistência personalizada e mais contextualizada. O desafio da Apple era ser a última das grande empresas a anunciar a integração de AI nos seus dispositivos e fazê-lo bem. Também pode ser uma vantagem, normalmente chegam atrasados, ams chegam bem: The Apple Way

Apresentaram o Apple intelligence (reparem que não é Artificial - nunca o disseram durante o Keynote e disseram Apple Intelligence umas 60 vezes) como um balde onde cabem todas as funcionalidades de AI que os dispositivos vão passar a ter. Não é a Siri, não é são as notas inteligentes, não é o reconhecimento de imagem - é tudo.

Vou dividir a análise em 3 partes: Capacidades gerais, Novo mecanismo de Intents e Privacidade & Modelos (e OpenAI).

Capacidades Gerais

Apresentaram algumas funcionalidades basais que vão estar disponíveis em todos os dispositivos (Mac, iPhone e iPad), para além daquelas que foram sendo mencionadas no texto acima, nos OS diferentes (Math Notes, Notas, Galeria). São elas:

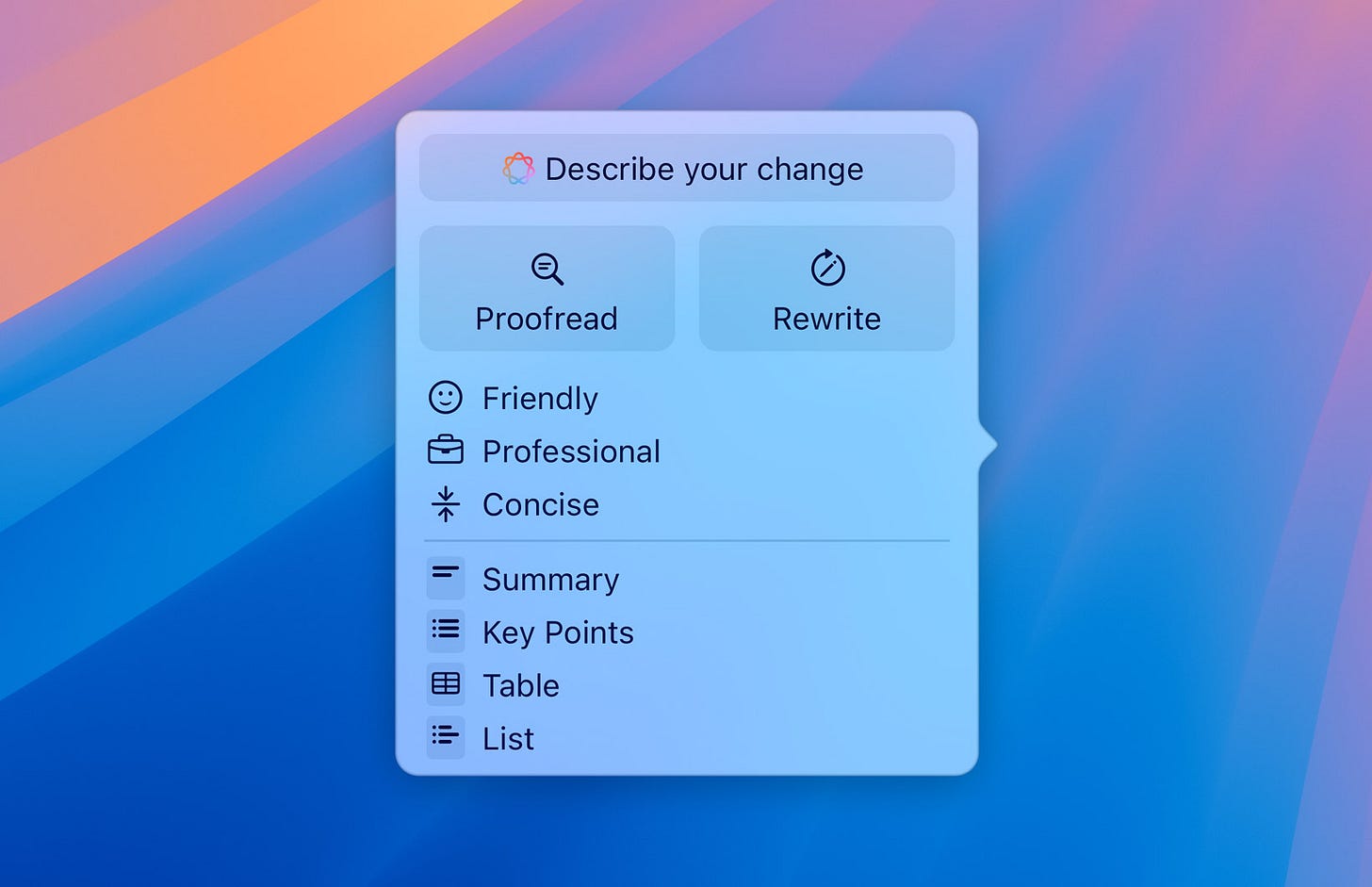

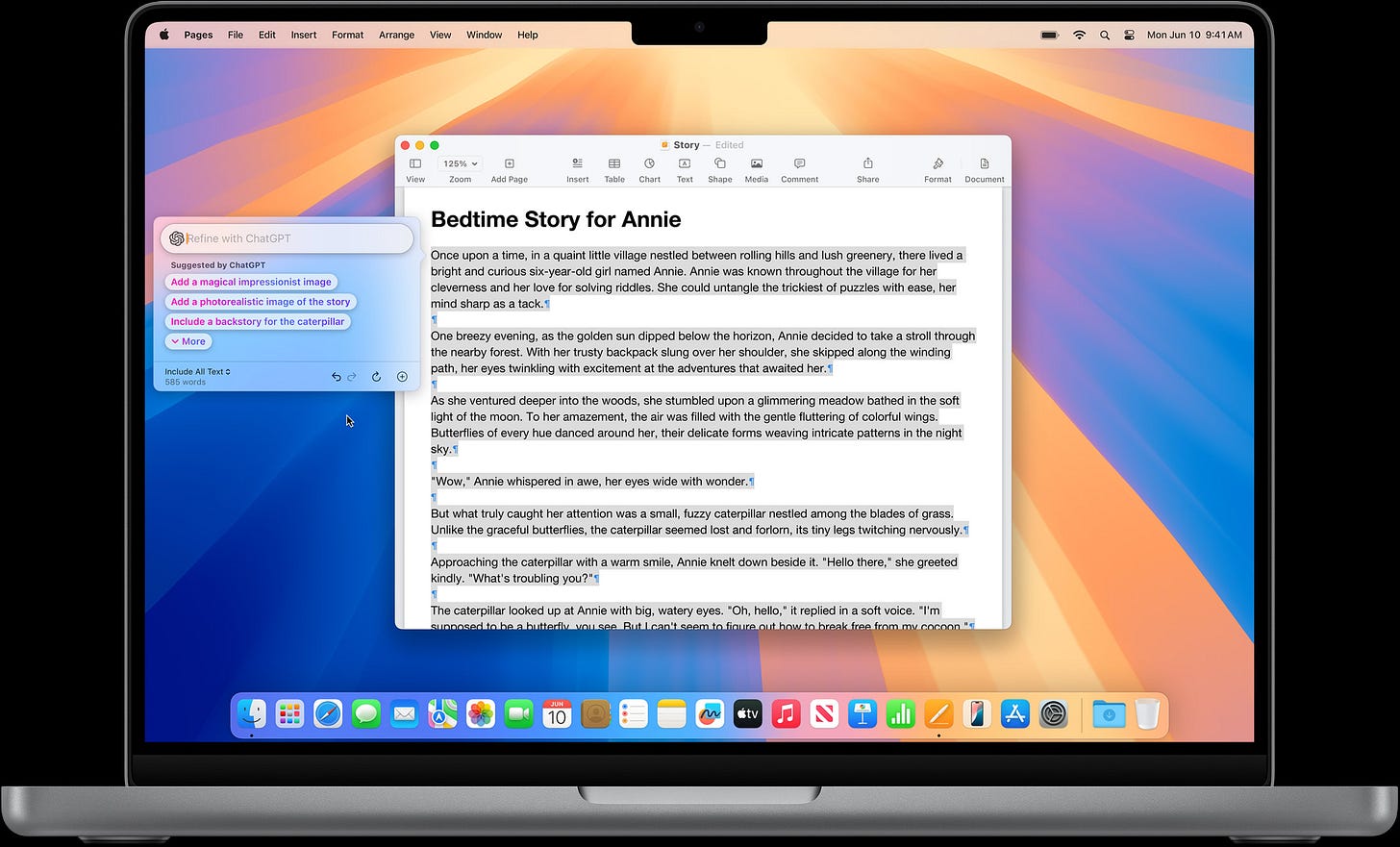

Rewrite: Disponibiliza uma série de ferramentas de escrita baseada em modelos genAI (LLMs) para ajudar os utilizadores a melhorarem o seu texto. Esta funcionalidades passam por coisas como correção ortográfica e gramatical (RIP Grammarly 🪦), mudanças de tom, geração de texto em formatos diferentes (tipo poesia) ou sumarização de texto. Esta funcionalidade passa a estar disponível automaticamente em qualquer local dos dispositivos que tenha uma caixa de texto, sem necessidade de incluir nada nas aplicações, por se tratar de algo que atua ao nível do sistema operativo.

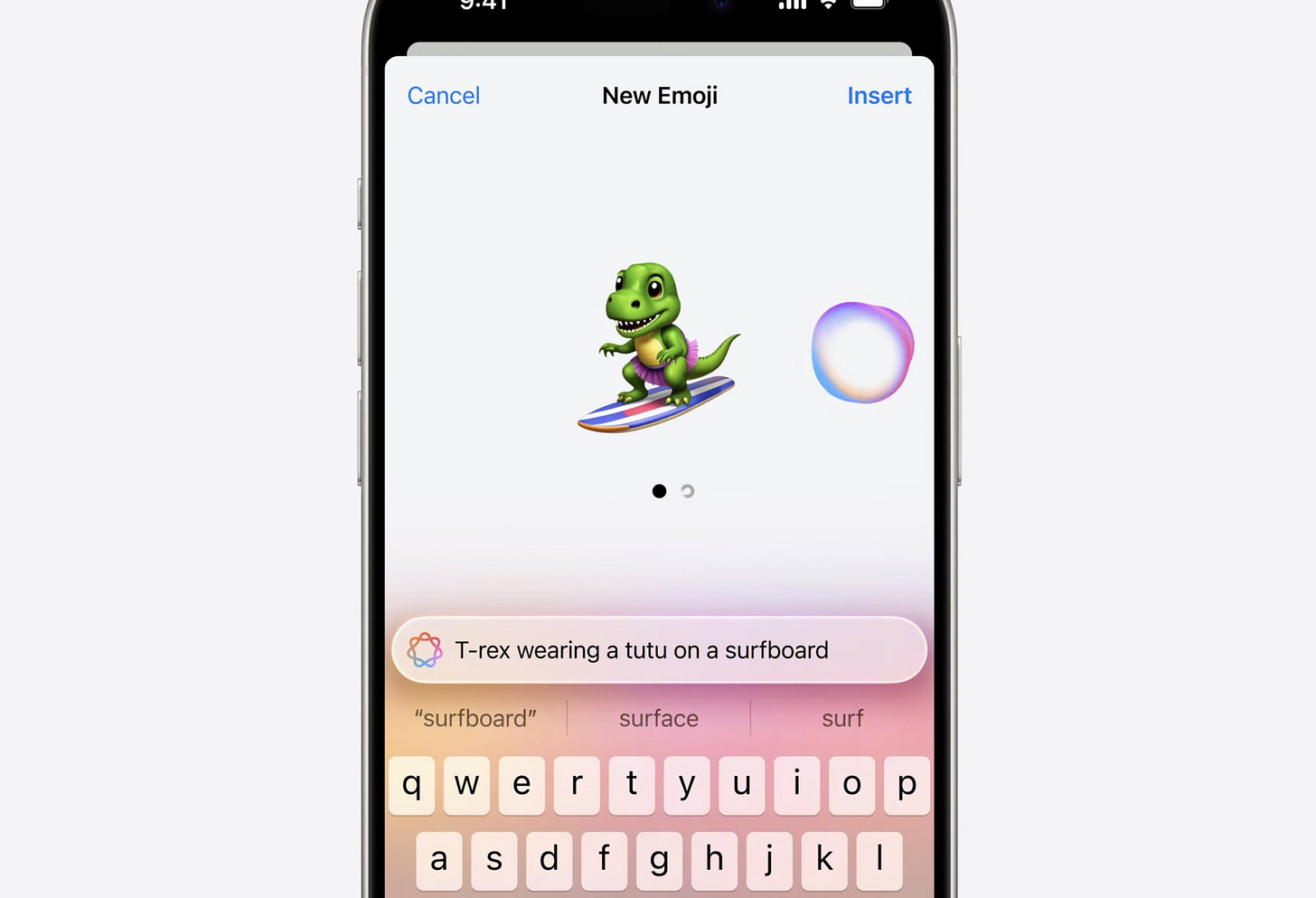

Image Playground: À semelhança do anterior, esta funcionalidade também estará disponível em qualquer lugar que possa receber uma imagem. Tal como o nome indica, é um gerador de imagens com genAI que utiliza modelos de difusão para o efeito. Permite gerar imagens combinando conceitos ou com uma prompt. E permite basear as imagens em fotografias dos nossos contactos por exemplo. Podemos escolher um de três estilos, animation, sketch ou illustration. Além disto, este Image Playground, que terá também uma app dedicada, vai conseguir gerar Genmojis - imagens ao estilo de emojis mas totalmente novas, combinando conceitos, para aqueles momentos em que o emoji perfeito não existe. Qual é o downside desta feature? Os emojis gerados poderão não ser bem interpretados por dispositivos não-Apple e transformam-se apenas em imagens (provavelmente com baixa resolução).

Notificações, Email e Mensagens: Os modelos de AI da Apple vão conseguir perceber o conteúdo dos nossos emails, mensagens e notificações para facilitar a nossa vida. Nos emails e mensagens, os modelos vão adicionar um resumo do que se passou com pontos de ação necessários - nunca mais vamos ter de ler 497 mensagens do nosso chat de grupo para perceber o que se passou. Nos emails, para além dos resumos o modelo vai identificar emails que pedem confirmação de presenças e torná-los mais relevantes e facilitar a resposta ao cruzar a informação com o calendário e gerar texto por nós (finalmente um serviço de secretariado 🙏). Nas notificações, os modelos serão capazes de perceber quais as prioritárias e trazê-las das profundezas das milhares de notificações para o topo. Também serão capazes de perceber se alguma notificação é relevante o suficiente para quebrar os modos de atenção ou não incomodar e fazê-la aparecer no ecrã.

Mecanismo de Intents (e Siri)

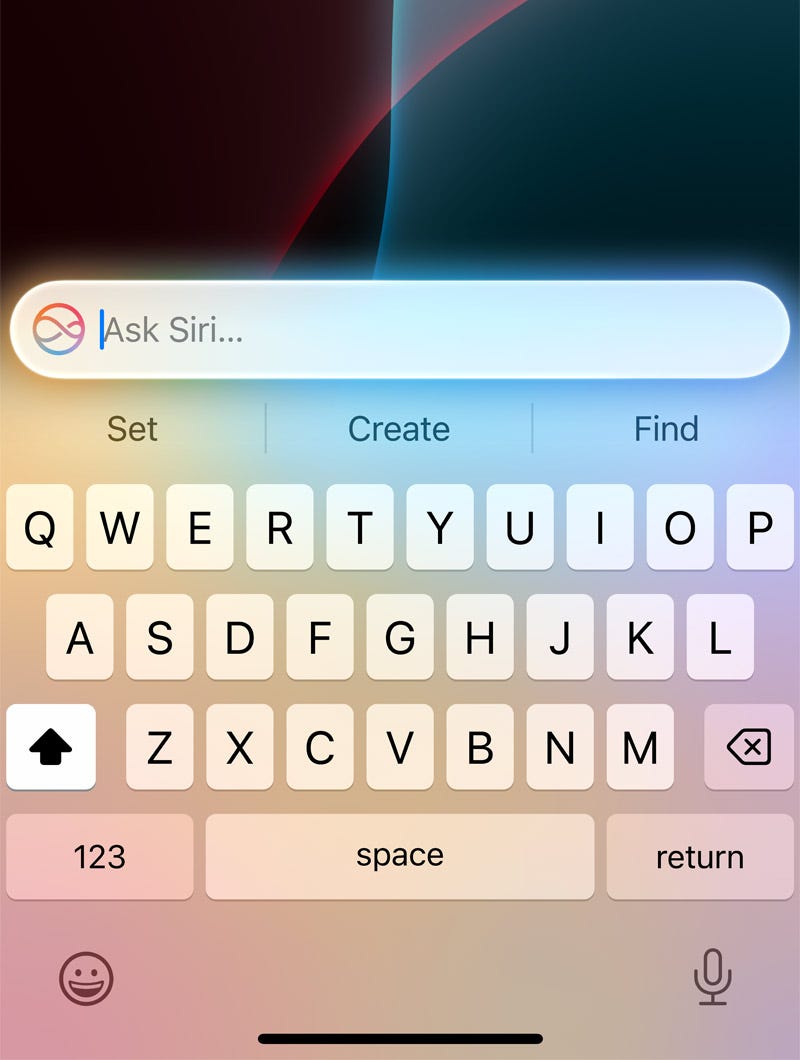

O Apple Intelligence não é a Siri mas a Siri é a cola desta inteligência toda.

Antes da parte interessante, o nosso assistente preferido recebeu um redesign de UI e UX e agora vai aparecer como um glow à volta do ecrã e vai ser possível escrever para falar com a Siri (à semelhança do chatGPT ou qualquer outro chtabot, na verdade).

Apresentaram a par disto um novo sistema core dos OS e da Siri que são os Intents (intenções) e que vão definir as capacidades que a Siri vai ter de interagir com o dispositivo e as aplicações. Um bom assistente virtual tem de ser capaz de responder a perguntas e de agir em nosso comando. Ações estas que deverão extravazar as funcionalidades básicas do telemóvel (ativar um alarme, colocar um temporizador, etc). Adicionalmente deveria pedir o menor contexto possível (já devia saber tudo sobre o utilizador, as nossas vidas estão nos smartphones) e não perder contexto da conversa entre as rondas de pedidos.

Com isto em mente, apresentaram uma série de ações que a Siri vai passar a ser capaz de fazer como procurar fotografias específicas (semelhante aos filtros na galeria), adicionar essa fotografia a uma nota com texto gerado sobre ela, responder a questões sobre informação que está no email ou nas mensagens como perguntar uma morada de um evento para qual recebi uma fotografia de um cartaz, reproduzir uma música que foi enviada por um amigo - uma série de ações que partem de um conhecimento profundo do utilizador e das suas relações pessoais, localização, etc.

Mas não fica por aqui! Os Intents vão poder ser usados pelos developers para configurarem ações que a Siri pode fazer. Imaginem: “Hey Siri, chama-me um Uber que me leve a casa desde a minha morada atual”, como se os Intents fossem APIs ou uns ganchinhos que a Siri pode puxar de cada aplicação para fazer acontecer coisas. Isto muda tudo:

Tal como já tinha falado num dos episódios de Shutdown, as aplicações passam a ser intermediárias de um serviço qualquer em que as interfaces visuais perdem alguma relevância e as interfaces conversacionais passam a ser mais importantes.

Os developers e as empresas terão de desenvolver estas ações, correndo o risco de, não o fazendo, este método se tornar o default e perderem relevância. O que traz novos desafios para os negócios - menos tempo nas aplicações, menos vender com as imagens, mas talvez mais subcrições para facilitar estes serviços.

A Siri passa a ser omnisciente, omnipresente e omnipotente. Vai saber e coordenar tudo o que é feito e vai poder controlar muito mais partes do dispositivo. E está aberta a terceiros e dependente deles para a tornar mais poderosa e útil. É a decisão a tomar: abrir o sistema e deixar muita gente contribuir para o tornar mais poderoso correndo o risco de baixar os standards de qualidade - algo novo para a Apple que sempre foi muito fechada.

RIP AI devices como o Humane AI Pin ou Rabbit R1, agora sim um assistente que tem informação do utilizador e é capaz de atuar nas coisas que já utiliza no seu dia-a-dia

Modelos & Privacidade (e OpenAI)

Estivemos até agora a falar de AI que sabe tudo sobre nós e que pode fazer coisas em nosso nome e que tem acesso às mensagens e email - e a privacidade que a Apple tanto preza?

A privacidade destas funcionalidades todas é garantida da mesma maneira que a Apple garante a privacidade do faceID e dos nossos cartões na Wallet e todas as outras coisas sensíveis - mantém tudo no dispositivo e não envia nada para a cloud.

… pelo menos numa primeira instância - já lá chego.

Os modelos (LLMs e difusão) que coordenam grande parte destas funcionalidades correm localmente nos chips dos telemóveis e computadores - foi para isto que andaram durante anos a apresentar chips cada vez mais poderosos e com os ditos Neural Engines. Isto faz com a que informação nunca deixe o dispositivo e seja enviada para um servidor, onde pode ser roubada ou gravada - é o método mais seguro. No entanto, há modelos e tarefas que não conseguem correr on-device, por questões de performance, latência, acesso à internet, consumo de bateria, envolvência de muitos dados, entre outros. E por estes motivos, para cumprir alguns pedidos, pode ser necessário transferir o trabalho de processamento para outro dispositivo, neste caso numa cloud. Com isto em mente, a Apple introduziu uma tecnologia/serviço que se chama Private Cloud Compute - uma maneira de correr estas tarefas mais complicadas na cloud, mantendo a segurança de privacidade dos dados.

Quando a questão do utilizador assim o demandar, os dados estritamente necessários (fotografias, contactos, mensagens, etc) são encriptadas e enviadas para um servidor privado construído pela Apple com Apple Silicon dentro (chips produzidos pela Apple) e com maior poder de computação do que o telemóvel. Assim que a tarefa é cumprida os dados são apagados e nunca são gravados em mais nenhum local. Ou seja, os dados são enviados para uma cloud mas a Apple garante que mantém a privacidade. Isto parece-me a melhor maneira de garantir o poder computacional necessário e manter a segurança dos utilizadores. Todos estes servidores e a sua segurança é verificável por terceiros numa abordagem blockchain-ish como descrito pelo próprio Craig.

Integração com a OpenAI e o chatGPT

Durante o demo do Apple Intelligence, também mostraram a integração que vão ter, ao nível do sistema operativo, com o chatbot mais famoso (e melhor) do momento: o chatGPT. Algo que deixou pessoas como Elon Musk e Satya Nadella muito desconfortáveis. Algumas perguntas:

Como vai funcionar isto? Quando a Siri detetar que o pedido terá uma melhor resposta com o modelo do chatGPT (gerar uma imagem mais realística, gerar código, etc), pergunta ao utilizador se pode partilhar os dados necessários com o chatGPT e transmite o pedido e devolve a resposta. Não é possível usar o chatGPT quando se quiser, depende do discernimento da Siri. Mais modelos serão adicionados às opções.

Os meus dados ficam protegidos? Sim, a OpenAI não fica com qualquer tipo de histórico dos dados nem pedidos antigos. Estas conversas não ficam gravadas e o IP do dispositivo é escondido para não poder ser agregado a pedidos feitos diretamente ao chatGPT.

Vai ter algum custo extra? Não. Os pedidos são geridos pela Apple e serão feitos ao último e mais poderoso modelo GPT-4o.

É raro ver a Apple a incluir third party software diretamente nos seus sistemas operativos, mas é uma boa indicação do caminho que querem traçar, uma prova de que pode ser feito com qualidade e que enriquecem a experiência do utilizador.

Algumas funcionalidades estarão disponíveis já no beta mas apenas em inglês, sendo o lançamento final e com mais línguas durante o próximo ano 2025.